![]() 关注我们,学习更多隐私合规讯息

关注我们,学习更多隐私合规讯息![]()

OpenAI的聊天机器人ChatGPT于2022年11月推出,几乎在一夜之间席卷全球

ChatGPT究竟是什么?

将一个新的技术术语引入主流:生成型人工智能。它描述了可以通过文本提示、自动完成计算机代码或分析情绪来创建新内容(如文章、图像和视频)的算法。

许多人可能不熟悉生成型人工智能的概念;其实,这并不是一项新技术。生成对抗性网络是生成模型的一种,于2014年引入。诸如GPT-3和BERT之类的大型语言模型被用来生成具有类人性质的文本。从那时起就开始迅速发展了。在过去的几年里,已经发布了各种生成型人工智能应用程序,包括GitHub copilot、DALL-E 2、Midtravel、Copy.AI、Notion AI和Lensa。

ChatGPT-4于2023年3月14日发布,是著名聊天机器人的最新最强的版本,它正在产生更惊人的输出。根据OpenAI的数据,ChatGPT-4在进行模拟律师考试时取得了比其前身GPT-3.5好得多的成绩。模拟律师考试是一种用于评估在美国执业资格的考试。GPT-4的成绩在前10%的考生中通过,而GPT-3.5的成绩在后10%。

在这种背景下,生成型人工智能被一些人视为人工智能领域最有希望的突破。到2032年,其全球市场规模预计将增长到2000亿美元以上。与此同时,它的快速发展突显了解决在各个领域使用生成型人工智能技术的道德和隐私问题越来越重要。

什么是人工智能幻觉?

随着生成型人工智能应用程序创造的新可能性,人们对风险的认知也随之提高。通常讨论的问题包括侵犯版权、生成算法中的固有偏见、高估人工智能能力,导致接收或传播错误的输出(也称为人工智能幻觉),以及创建deepfakes和其他合成内容,这些内容可能操纵公众舆论或对公共安全构成风险。

除了这些关键问题外,生成型人工智能还对个人、组织和社会带来了复杂的隐私风险。关于敏感信息和聊天历史泄露的最新报告强调,在开发和部署生成型人工智能技术时,迫切需要强有力的隐私和安全措施。

全球公认的隐私原则,如数据质量、数据收集限制、目的规范、使用限制、安全性、透明度、问责制和个人参与,适用于处理个人数据的所有系统,包括训练算法和生成人工智能。

人工智能对隐私合规的影响

首先,生成型人工智能聊天机器人目前正在使用在混合数据集上训练的大型语言模型,包括从互联网上收集的数据。全球隐私管辖区对此的监管方式差异很大,总体上受到广泛的法律考虑。

☝一方面,美国各州的隐私法规,如《加州消费者隐私法》和《加州隐私权法》,将企业有合理依据相信合法向公众提供的信息排除在其范围之外。

尽管如此,当网站的使用条款明确禁止数据提取时,它仍然会给网络爬虫带来责任风险。当被抓取的数据包括本应受到密码保护的信息时,可能会出现隐私问题。

✌另一方面,根据《欧盟通用数据保护条例》,公共数据的收集、存储和处理需要明确的法律依据。此外,未能保护个人数据不被窃取侵犯了网站提供商保护用户数据的义务,并使个人面临风险。

第二个问题是透明度,无论是在一般隐私背景下还是在人工智能系统的特定背景下。监管部门普遍认为,向个人提供的有关其数据如何收集和处理的信息应该是可访问的,并且足够详细,以使他们能够行使权利。

简言之,使用人工智能的组织应该能够向可能不熟悉最新技术的最终用户解释该系统是如何做出决策的。联邦贸易委员会发布了数据代理指南,建议他们对数据收集和使用做法保持透明,并实施合理的安全措施来保护消费者数据。当试图翻译和预测算法预测时,这两个要求都不容易实现。

第三个问题——也许也是机器学习中最具挑战性的隐私问题之一——是如何行使个人数据隐私权。“被遗忘权”是一项重要的全球性盈利权利,它允许个人请求公司删除其个人信息。虽然从数据库中删除数据相对容易,但从机器学习模型中删除数据可能很困难,这样做可能会破坏模型本身的实用性。

这些问题和例子只是生成型人工智能潜在隐私问题的冰山一角

研究表明,用于训练生成型人工智能算法和大型语言模型的私人信息可能会作为聊天机器人的输出出现,或在网络攻击中被恢复。这强调组织和隐私专业人士都需要认真研究隐私原则以及需要回答哪些问题,以评估应用程序是否符合隐私法规。联邦贸易委员会最近的决定下令销毁针对非法收集的个人信息训练的算法,这发出了一个非常明确的信息。

快速发展的人工智能如何监管?

与此同时,有人呼吁在更广泛的人工智能道德使用背景下审查与隐私相关的问题。人工智能的快速发展使公众没有一个明确的法律框架来妥善处理这项技术,从而将确定适当的人工智能治理策略的任务留给了各个组织。

虽然随着时间的推移,通过立法(例如《欧盟人工智能法案》),指导方针可能会变得更加清晰和一致,但组织今天可以采取一些措施,使其负责任地使用人工智能与隐私原则相一致。

在过去的几年里,已经出现了一套定义人工智能负责任使用的原则,包括问责制、人工干预、准确性、安全性、偏见预防和自动化决策的可解释性。

正如IAPP和FTI咨询公司最近关于人工智能治理和隐私的一份报告所显示的那样,大多数组织已经制定或正在制定负责任地使用人工智能的内部准则。这些努力通常由内部隐私办公室推动和协调。组织可以扩展现有的、成熟的隐私计划和流程,以评估隐私风险,包括更广泛的道德评估,防止基于歧视性陈述的偏见输出。

考虑到生成型人工智能和整个基础模型领域带来的机遇和风险,公司将需要对隐私进行持续投资,提高算法审计的技能,并整合“设计的道德、隐私和安全”方法。

如何保护个人隐私?

反机器人系统或网络应用程序防火墙可以保护在线数据不被抓取。“机器遗忘”等令人讨厌的研究领域旨在解决从机器学习模型中删除数据的问题,以解决个人隐私权问题。

机器学习方法,如带有人类反馈的强化学习,可以支持更准确的模型训练并提高性能。展望未来,新兴的隐私增强技术,如差异隐私,开发可扩展的数据集清理方法,包括通过消除重复或训练数据披露要求,也可能有助于解决许多这些悬而未决的问题。

随着时间的推移,实践和试错,隐私和工程界将继续决定如何利用我们时代的创新发展,并围绕这些主题的行业标准做出贡献

*文章来源:iapp官网

*原标题:生成式 AI:隐私和技术视角

*整理编辑:A隐小私(yinxiaosi00)

■ DEPTH

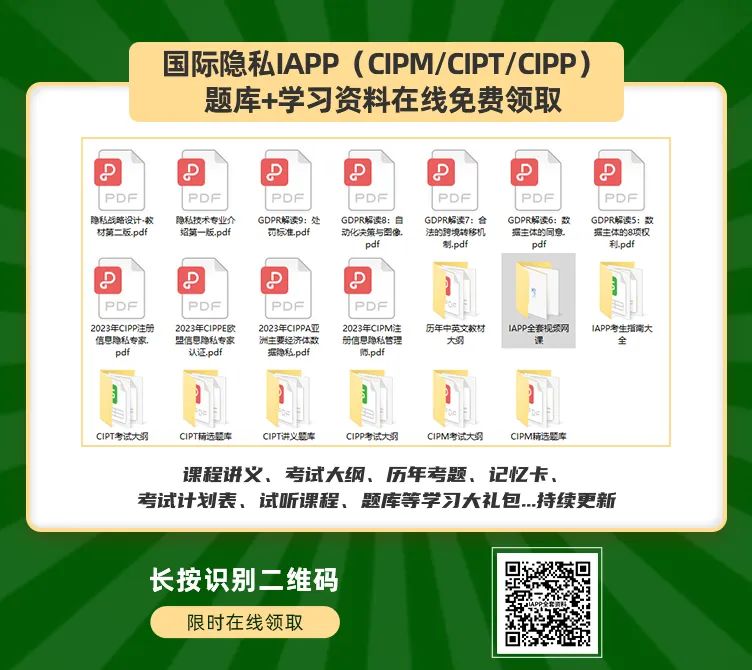

想了解IAPP哪个证书适合你?

全套资料长按扫码领取

■ DEPTH

什么是IAPP国际隐私证?

一起了解IAPP证书

-End-

■ DEPTH

想了解IAPP哪个证书适合你?

资格评估可直接扫码

免费评估/赠送一份国际隐私认证学习资料一份

觉得不错你就赞赞我吧!

点分享

点点赞

点在看

戳这,领取IAPP备考资料包